OpenAI đang mở rộng quy trình an toàn nội bộ để đối mặt với nguy cơ của trí tuệ nhân tạo có hại. Một “nhóm tư vấn an toàn” mới sẽ đặt ở mức cao hơn các nhóm kỹ thuật và đưa ra các đề xuất cho lãnh đạo, và hội đồng đã được ban quyền phê duyệt — tuy nhiên, việc họ sẽ sử dụng quyền này hay không là một câu hỏi khác.

Thường thì, chi tiết của các chính sách như vậy không cần thiết phải được đề cập, vì thực tế chúng đều dựa vào nhiều cuộc họp nội bộ với các chức năng và trách nhiệm mà người ngoại vi hiếm khi được biết đến. Tuy nhiên, điều này có lẽ cũng đúng trong trường hợp này, cuộc tranh cãi về lãnh đạo gần đây và cuộc thảo luận nguy cơ về trí tuệ nhân tạo đang phát triển đều đáng xem xét cách công ty phát triển trí tuệ nhân tạo hàng đầu thế giới đang tiếp cận các vấn đề an toàn.

Trong một tài liệu và bài đăng trên blog mới, OpenAI thảo luận về “Khung cảnh Sẵn Sàng” được cập nhật của họ, mà một người có thể tưởng tượng đã được chỉnh sửa một chút sau sự chao đảo của tháng 11 loại bỏ hai thành viên “chống tiến triển” của hội đồng: Ilya Sutskever (vẫn làm việc tại công ty với một vai trò có chút thay đổi) và Helen Toner (hoàn toàn rời đi).

Mục đích chính của bản cập nhật dường như là để thể hiện một con đường rõ ràng để xác định, phân tích và quyết định làm gì về các rủi ro “thảm họa” tồn tại trong các mô hình mà họ đang phát triển. Như họ định nghĩa:

Bằng rủi ro thảm họa, chúng tôi nghĩa là bất kỳ rủi ro nào có thể dẫn đến hàng trăm tỷ đô la thiệt hại kinh tế hoặc dẫn đến tổn thương nặng hoặc tử vong của nhiều người — điều này bao gồm, nhưng không giới hạn, rủi ro tồn tại.

(Cái gọi là rủi ro tồn tại là loại rủi ro “sự trỗi dậy của máy móc”.)

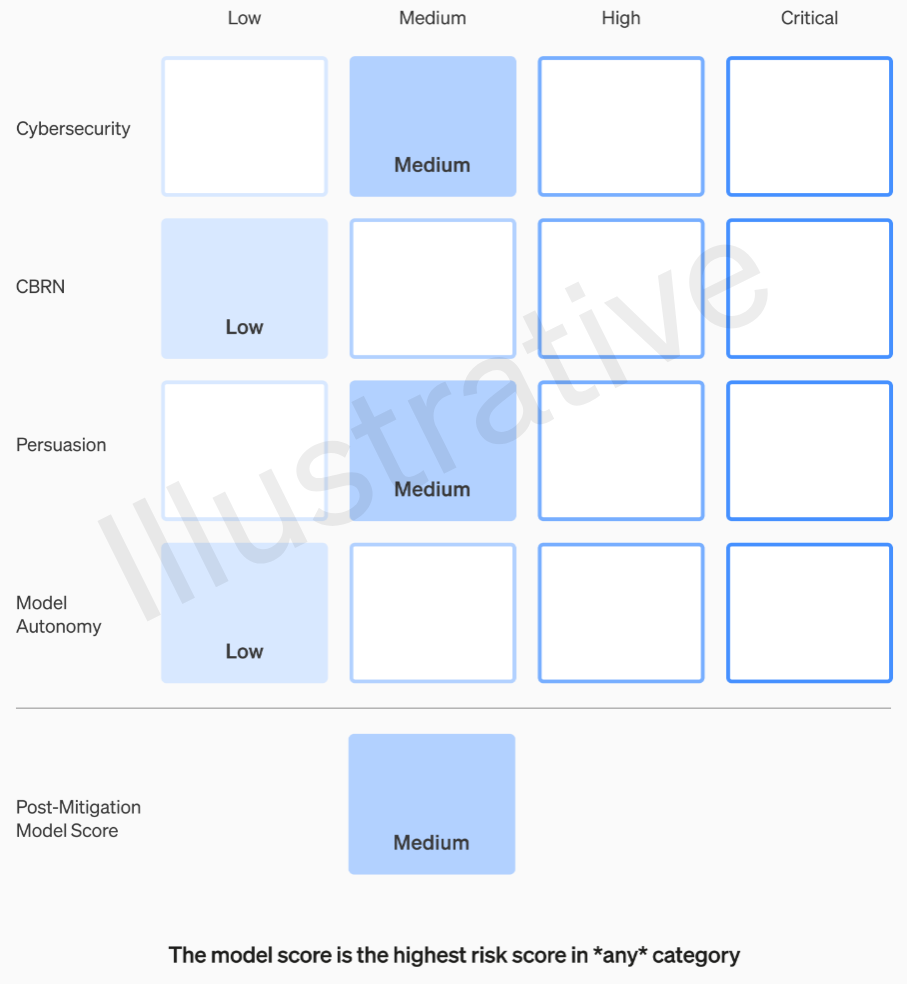

Các mô hình đang hoạt động được quản lý bởi một nhóm “hệ thống an toàn”; điều này là để, ví dụ, giảm thiểu việc lạm dụng hệ thống ChatGPT có thể được giảm bớt bằng các hạn chế API hoặc điều chỉnh. Các mô hình biên giới đang phát triển thuộc về nhóm “sẵn sàng”, nơi cố gắng xác định và định lượng rủi ro trước khi mô hình được phát hành. Và sau đó có nhóm “siêu phù hợp”, đang làm việc về hướng dẫn lý thuyết cho các mô hình “siêu thông minh”, mà chúng ta có thể hoặc không thể đã ở gần. Hai loại đầu tiên, có thật và không hư cấu, có một hệ thống rủi ro khá dễ hiểu. Các nhóm của họ đánh giá mỗi mô hình theo bốn hạng mục rủi ro: an ninh mạng, “thuyết phục” (ví dụ: tin giả mạo), tự động hóa mô hình (tức là, hoạt động tự quyết) và CBRN (hóa học, sinh học, hạt nhân và hạt nhân; ví dụ: khả năng tạo ra chủng vi khuẩn mới). Các biện pháp giảm nhẹ khác nhau được giả định: Ví dụ, việc mô tả quá trình làm napalm hoặc bom ống một cách hợp lý. Sau khi xem xét các biện pháp giảm nhẹ đã biết đến, nếu một mô hình vẫn được đánh giá có rủi ro “cao”, nó sẽ không thể triển khai, và nếu một mô hình có bất kỳ rủi ro “criticial” nào, nó sẽ không được phát triển thêm.

Các mức rủi ro này thực sự được ghi chép trong khung cảnh, nếu bạn đang tự hỏi liệu chúng có để lại cho sự đánh giá của một kỹ sư hay quản lý sản phẩm nào đó không.

Ví dụ, trong phần an ninh mạng, đó là phần thực tế nhất, việc “tăng hiệu suất của các nhà điều hành… trong các nhiệm vụ chiến lược an ninh mạng chính” một cách nhất định được xem là rủi ro “trung bình.” Một mô hình có rủi ro cao, ngược lại, sẽ “xác định và phát triển bằng chứng thực nghiệm cho những cuộc tấn công giá trị cao vào mục tiêu được bảo vệ mà không cần sự can thiệp của con người.” Critical là “mô hình có thể lên kế hoạch và thực hiện chiến lược mới từ đầu đến cuối cho các cuộc tấn công mạng mới vào mục tiêu được bảo vệ chỉ dựa trên một mục tiêu mong muốn ở mức cao.” Rõ ràng là chúng ta không muốn điều đó (mặc dù nó có thể bán được với một số số tiền đáng kể).

Tôi đã yêu cầu OpenAI cung cấp thêm thông tin về cách các danh mục này được định nghĩa và làm tinh tế hơn — ví dụ, nếu một rủi ro mới như video giả mạo chân thật của con người thuộc vào “thuyết phục” hay một danh mục mới — và sẽ cập nhật bài đăng này nếu có phản hồi.

Vì vậy, chỉ có thể chấp nhận các mức rủi ro “trung bình” và “cao” một cách nào đó. Nhưng những người tạo ra những mô hình đó không nhất thiết là những người tốt nhất để đánh giá và đưa ra các đề xuất. Vì lý do đó, OpenAI đang tạo ra một “Nhóm Tư vấn An toàn Chức năng Chéo” sẽ đặt ở trên phía kỹ thuật, xem xét báo cáo của các chuyên gia và đưa ra các đề xuất bao gồm một tầm nhìn rộng hơn. Hy vọng rằng điều này (họ nói) sẽ phát hiện ra một số “không biết chưa biết,” mặc dù theo bản chất, chúng khá khó bắt gặp. Quy trình yêu cầu những đề xuất này được gửi đồng thời đến hội đồng và lãnh đạo, điều mà chúng tôi hiểu là CEO Sam Altman và CTO Mira Murati, cùng với các phụ tá của họ. Lãnh đạo sẽ đưa ra quyết định về việc triển khai hay ngưng lại, nhưng hội đồng có thể đảo ngược những quyết định đó.

Hy vọng rằng những biện pháp này sẽ ngăn chặn bất kỳ tình huống nào giống như những gì đã được đồn đại trước đây, nơi một sản phẩm hoặc quy trình có rủi ro cao đã được phê duyệt mà không có sự nhận thức hoặc chấp thuận của hội đồng quản trị. Tất nhiên, kết quả cuối cùng của tình huống này là sự loại bỏ hai thành viên quan trọng của hội đồng, cũng như sự bổ nhiệm những người không chuyên sâu về trí tuệ nhân tạo (Bret Taylor và Larry Summers).

Nếu một nhóm chuyên gia đưa ra khuyến nghị và Giám đốc điều hành đưa ra quyết định dựa trên thông tin đó, liệu hội đồng quản trị thân thiện này có thực sự có quyền phản đối và ngăn chặn họ không? Và nếu họ thực sự làm điều này, liệu chúng ta có được thông tin về nó không? Tính minh bạch không được đảm bảo ngoại trừ lời hứa rằng OpenAI sẽ mở cửa cho các cuộc kiểm toán từ các bên thứ ba độc lập.

Giả sử một mô hình đang phát triển được xác định thuộc loại rủi ro “nghiêm trọng”. Trước đó, OpenAI đã từng cảnh báo về loại rủi ro này – nói về sức mạnh lớn của mô hình của họ và mức độ từ chối phát hành chúng, là một cách quảng cáo xuất sắc. Nhưng liệu chúng ta có thể tin tưởng rằng điều này sẽ xảy ra nếu rủi ro là thực tế và OpenAI thực sự quan tâm đến chúng? Điều này có lẽ là một nguyên tắc lý tưởng, nhưng không chắc chắn liệu nó có được thảo luận đầy đủ.